RAPPORTO BAIN

https://www.bain.com/globalassets/noindex/2024/bain_report_technology_report_2024.pdf

L’intelligenza artificiale cambia i grandi e piccoli sistemi informatici

I data center diventeranno più grandi e una maggiore quantità di elaborazione si sposterà più vicino all’edge.

Di Arjun Dutt, Paul Renno e Velu Sinha

25 settembre 2024

L’insaziabile appetito dell’intelligenza artificiale per la potenza di calcolo stimolerà la crescita dei data center, dagli attuali 50-200 megawatt a più di un gigawatt.

L’intelligenza artificiale trasformerà anche l’edge computing, poiché modelli linguistici di piccole dimensioni e specifici per dominio supporteranno attività che richiedono una latenza inferiore.

Questi cambiamenti metteranno a dura prova le catene di approvvigionamento già sotto pressione, poiché i leader si contendono le risorse, in particolare manodopera ed elettricità.

Con l’evoluzione dei data center e dell’edge computing, le aziende potrebbero dover rivalutare le proprie posizioni di mercato e rivedere le proprie ambizioni strategiche.

Esplora il report

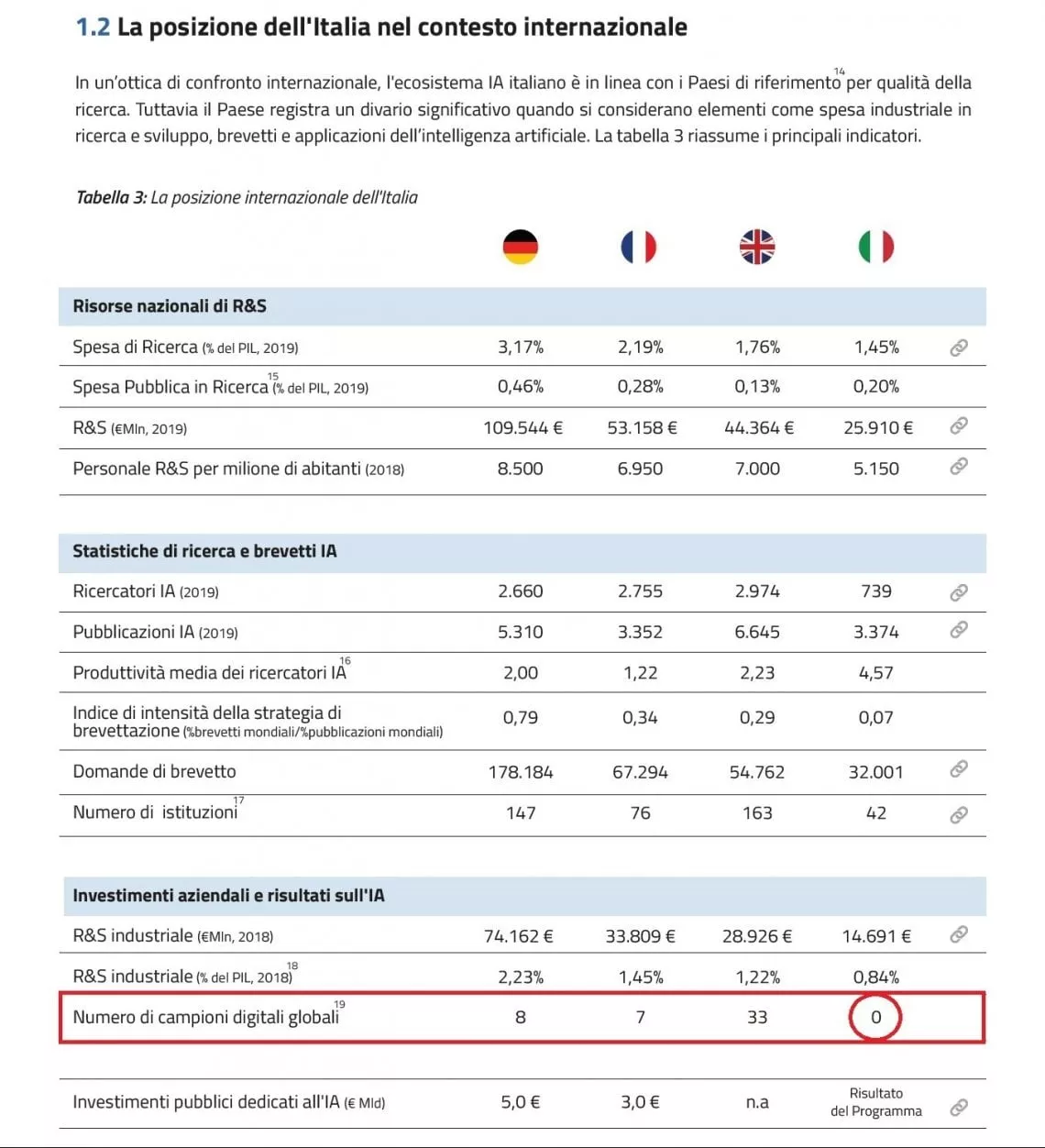

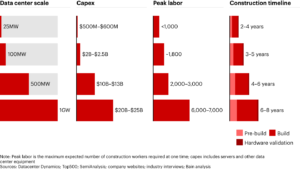

La necessità di potenza di calcolo dell’IA amplierà radicalmente la scala dei grandi data center nei prossimi cinque-dieci anni. Oggi, i grandi data center gestiti da provider di servizi cloud hyperscale vanno da 50 megawatt a oltre 200 megawatt. Gli enormi carichi richiesti dall’IA porteranno queste aziende a esplorare data center nell’intervallo da 1 gigawatt e oltre. Ciò avrà enormi implicazioni sugli ecosistemi che supportano questi centri (tra cui ingegneria delle infrastrutture, produzione di energia e raffreddamento) e influenzerà le valutazioni di mercato. I requisiti architettonici per ottenere la densità di elaborazione, potenza elettrica e raffreddamento necessaria per i data center da gigawatt influenzeranno la progettazione di molti data center più piccoli (vedere Figura 1).

Figura 1

I requisiti dei data center aumenteranno in modo significativo per soddisfare le esigenze di elaborazione dell’intelligenza artificiale

L’ubiquità dell’AI cambierà anche la natura dell’edge computing. Saranno necessari modelli di linguaggio specifici per dominio, più piccoli, più semplici e ottimizzati per scopi specifici, per gestire i carichi di elaborazione che potrebbero richiedere una risposta più rapida, una latenza inferiore o essere in grado di utilizzare un modello più semplice grazie a un focus ristretto. L’innovazione all’avanguardia si estenderà al fattore di forma dei dispositivi utente, che cambierà anche per soddisfare le esigenze delle persone che interagiscono con l’IA.

Le implicazioni di questi cambiamenti saranno trasformative in una serie di dimensioni critiche, tra cui la velocità dello sviluppo tecnologico, la leadership di settore, la produzione e il consumo di energia, le catene di fornitura di edilizia e industriali, le considerazioni ambientali, l’economia di mercato, gli interessi della sicurezza nazionale e i finanziamenti e gli investimenti. Per rimanere al top del mercato, i leader dovranno effettuare livelli di investimento senza precedenti nell’infrastruttura tecnologica. Se i grandi data center attualmente costano tra 1 e 4 miliardi di dollari, i costi per i data center tra cinque anni potrebbero essere compresi tra 10 e 25 miliardi di dollari.

Pressione sulle risorse

Le richieste di potenza e i prezzi di questi grandi data center imporranno limiti a quanti ne possono essere costruiti e con quale rapidità. La corsa all’acquisizione di risorse AI sta già creando una competizione estrema per le risorse nella fascia alta del mercato e i crescenti requisiti dei data center metteranno ulteriormente a dura prova le capacità.

Il consumo di energia è un esempio critico. Le utility stanno già rispondendo alle richieste dei clienti hyperscaler per espandere significativamente la capacità elettrica nei prossimi cinque anni. Le loro esigenze saranno in competizione con la crescente domanda di veicoli elettrici e il re-shoring della produzione, stressando la rete elettrica. La crescita della domanda di elettricità è stata sostanzialmente piatta negli ultimi 15-20 anni, ma gli investimenti per espandere e rafforzare la rete e aggiungere nuove fonti di energia (tra cui la generazione in loco e le energie rinnovabili) dovranno aumentare in modo significativo.

I fornitori di infrastrutture e le catene di fornitura tecnologiche, tra cui networking, memoria e storage, stanno investendo anche per soddisfare le richieste di elaborazione ad alte prestazioni da parte di hyperscaler, aziende di servizi digitali e aziende. I grandi data center spingeranno i limiti e scateneranno l’innovazione nella progettazione fisica, nel raffreddamento a liquido avanzato, nell’architettura del silicio e nella progettazione congiunta di hardware e software altamente efficiente per supportare l’ascesa dell’IA.

I grandi data center richiedono grandi sforzi costruttivi e richiedono cinque anni o più.La domanda di manodopera edile e specializzata, fino a 6.000-7.000 lavoratori ai massimi livelli, metterà a dura prova la riserva di manodopera. La carenza di manodopera nel settore elettrico e del raffreddamento potrebbe essere particolarmente acuta. Molti progetti che si verificano contemporaneamente metteranno a dura prova l’intera filiera, dalla posa dei cavi all’installazione di generatori di riserva.

Innovazione al limite

Mentre le aziende valutano i compromessi tra cloud ed edge computing per l’intelligenza artificiale, decidere dove gestire l’inferenza è fondamentale. Una considerazione è quanto concentrarsi su domini e attività specifiche, al fine di utilizzare dati meglio curati e più mirati per creare modelli mirati che riducano il carico dell’infrastruttura di elaborazione.

Un altro problema è come spostare più potenza di calcolo più vicino all’edge per l’IA in ambienti con bassa tolleranza per la latenza, come la guida autonoma. L’ascesa di modelli più piccoli e di elaborazione specializzata in grado di eseguire questi modelli all’edge sono passi importanti in questa direzione. Nel frattempo, il settore sta rapidamente sviluppando nuovi fattori di forma per l’edge, tra cui server AI edge, PC AI, robot, altoparlanti e dispositivi indossabili.

Preparativi per l’espansione

La natura mutevole dei data center e dell’edge computing aumenta la probabilità che l’IA riorganizzi il settore tecnologico e stabilisca un nuovo ordine per la prossima era. Le aziende di tutto il settore dovrebbero esaminare la propria posizione di mercato e riconsiderare le ambizioni strategiche per garantire di rimanere competitive nei domini scelti.

Fornitori di servizi cloud e data center. La sfida principale per i grandi player in questa fascia di mercato sarà trovare modi per far sì che le loro capacità di intelligenza artificiale soddisfino le future richieste dei loro clienti. I provider dovranno decidere cosa fornire come servizio e cosa fornire come tecnologie abilitanti a livello di settore. I loro sforzi si concentreranno anche sull’accelerazione dello sviluppo del modello e sul lavoro attraverso la supply chain per costruire data center grandi e distribuiti. Ciò richiederà la capacità di riconcentrarsi su opportunità interessanti, creare rapidamente capacità e formare partnership che rafforzino la piattaforma. Meta, ad esempio, sta competendo con OpenAI, Alphabet e altri per assicurarsi un ruolo di leadership nei grandi modelli linguistici. Per supportare queste ambizioni, Meta ha aumentato massicciamente la scala della sua capacità di elaborazione negli ultimi due anni. Meta ha anche rilasciato Llama come modello linguistico open source, per fungere da abilitatore nell’ecosistema più ampio.

Fornitori di infrastrutture. I carichi di lavoro AI richiedono una maggiore specializzazione rispetto alle generazioni precedenti di elaborazione. Le aziende che progettano e producono server, reti, storage, raffreddamento, alimentazione, cablaggio e tutti gli altri elementi che vanno a costituire un data center dovranno progettare i loro prodotti per supportare l’AI. Svilupperanno soluzioni su scala per ottimizzare l’elaborazione e le prestazioni del software AI. Queste aziende svolgono anche un ruolo significativo nella fornitura di infrastrutture e servizi ai clienti. Accelerare il time-to-market dell’AI è un’importante opportunità per le aziende.

I fornitori di software continueranno a infondere l’intelligenza artificiale nei loro prodotti principali per rimanere competitivi. Sempre più spesso, la loro attività dovrà concentrarsi sull’acquisizione e l’interpretazione di insight sui dati, ottimizzando al contempo i modelli linguistici per offrire risultati migliori (e più rapidi) ai clienti. Questi aspetti della loro attività si completeranno a vicenda man mano che i fornitori di software svilupperanno le loro capacità per aumentare le competenze della forza lavoro dei loro clienti.

I produttori di dispositivi edge troveranno il modo di capitalizzare l’innovazione nell’intero ecosistema, testando nuovi fattori di forma e interfacce e utilizzando l’intelligenza artificiale per aumentare la personalizzazione sui dispositivi. L’ordinamento delle preferenze di privacy degli utenti sarà fondamentale per aumentare i tassi di adozione.

I fornitori di catene di fornitura di data center hanno un’opportunità formativa di rimodellare i loro ruoli nel mercato man mano che i mega center proliferano e l’edge computing si evolve. Questi attori si concentreranno sulla creazione di capacità di scalabilità e sullo sviluppo di partnership significative con aziende di ingegneria che possono aiutare a soddisfare le sfide dei grandi data center e dell’edge computing più sofisticato.

Mentre gli hyperscaler e altre grandi aziende pianificano i grandi data center necessari per soddisfare le esigenze dell’IA, anche altri fattori richiederanno di essere presi in considerazione. Tra questi, i requisiti di investimento potrebbero essere di primaria importanza, poiché le aziende competono per il finanziamento di molti progetti massicci contemporaneamente. Le tensioni sulla rete elettrica sono un’altra area in cui le aziende hanno un controllo diretto limitato. Potrebbero anche dover gestire le implicazioni ambientali dell’espansione dei data center e dell’uso dell’elettricità, inclusi gli effetti sulle loro impronte di carbonio e le promesse di riduzione delle emissioni. Le sfide sono ampie e complesse, ma mentre la corsa globale per vincere nell’IA si intensifica, nessuna azienda in questo ecosistema può permettersi di restare a guardare e aspettare; il momento di agire è adesso.

Alessandro Aresu, Geopolitica dell’intelligenza artificiale, Feltrinelli, 2024, pp. 576;

L’intelligenza artificiale è l’invenzione definitiva dell’umanità. La sua comparsa sulla scena evoca il rischio dell’estinzione del suo creatore, poiché la sua diffusione porterà, forse, al suo superamento. Queste visioni apocalittiche pervadono ormai il discorso pubblico sulla tecnologia, in un mondo dove la stessa espressione “intelligenza artificiale” è divenuta onnipresente e ossessiva. Sono temi tutt’altro che nuovi per le loro profonde radici filosofiche e per i pionieri che, in vari ambiti, li hanno alimentati nel corso del Novecento; eppure, qualcosa di significativo è già accaduto e siamo spettatori di connessioni di cui non cogliamo pienamente il significato. Il dibattito sull’intelligenza artificiale chiama poi in causa alcuni concetti chiave, tra cui l’origine dell’intelligenza stessa, ciò che sappiamo e ignoriamo del cervello e del pensiero; l’idea di un’intelligenza “generale” applicata alle macchine; i limiti quantitativi e qualitativi del calcolo; il problema dell’allineamento della tecnologia ai nostri bisogni e ai nostri valori. Ma quali aziende alimentano questi processi? E quali sono le loro implicazioni in un mondo radicalmente diviso, dilaniato dalla guerra tecnologica tra Stati Uniti e Cina, che attraversa l’infrastruttura e gli usi dell’intelligenza artificiale, e la corsa alle risorse, economiche e materiali, necessarie al suo continuo sviluppo? Alessandro Aresu ci racconta l’intreccio di relazioni tra filosofi, scienziati e imprenditori che stanno plasmando questo mondo, come “Jensen” Huang, fondatore di NVIDIA e protagonista assoluto della rivoluzione tecnologica intorno all’AI, “Bill” Dally, informatico e mente scientifica dietro ai portentosi microchip che rendono possibile l’evoluzione dell’AI, ma anche il rapporto tra il Cynar e i pionieri di DeepMind, oltre che le storie dei manager meno conosciuti che operano in OpenAI. Ci aiuta così a comprendere il presente e i possibili scenari futuri, segnati dalla rivoluzione dell’intelligenza artificiale, le lotte tra le aziende impegnate nello sviluppo dell’AI definitiva e le ripercussioni geopolitiche negli equilibri mondiali. L’intelligenza artificiale è l’invenzione definitiva dell’umanità.

Leggi anche: